Swimmer¶

此環境是 Mujoco 環境的一部分,其中包含關於環境的一般資訊。

Action Space |

|

Observation Space |

|

import |

|

描述¶

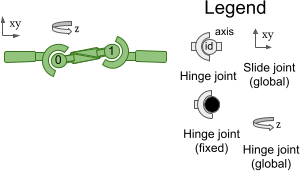

此環境對應於 Rémi Coulom 的博士論文 “Reinforcement Learning Using Neural Networks, with Applications to Motor Control” 中描述的 Swimmer 環境。此環境旨在增加相較於經典控制環境的獨立狀態和控制變數數量。Swimmers 由三個或更多段(「links」)和少一個關節(「rotors」)組成 - 一個 rotor 關節連接兩個 links 以形成線性鏈。Swimmer 懸浮在二維池中,並且始終在相同位置開始(受到從均勻分佈中抽取的一些偏差影響),並且目標是通過對 rotors 施加扭矩並使用流體摩擦,盡可能快地向右移動。

註解¶

問題參數如下:問題參數

n: 身體部件數量

mi: 部件 i 的質量 (i ∈ {1…n})

li: 部件 i 的長度 (i ∈ {1…n})

k: 黏性摩擦係數

雖然預設環境具有 n = 3、li = 0.1 和 k = 0.1。可以在建構期間傳遞自訂 MuJoCo XML 檔案以增加連結數量,或調整任何參數。

Action Space¶

Action space 為 Box(-1, 1, (2,), float32)。Action 代表在 links 之間施加的扭矩

編號 |

Action |

控制最小值 |

控制最大值 |

名稱(在對應的 XML 檔案中) |

關節 |

類型(單位) |

|---|---|---|---|---|---|---|

0 |

施加在第一個 rotor 上的扭矩 |

-1 |

1 |

motor1_rot |

hinge |

扭矩 (N m) |

1 |

施加在第二個 rotor 上的扭矩 |

-1 |

1 |

motor2_rot |

hinge |

扭矩 (N m) |

Observation Space¶

Observation space 由以下部分組成(依序)

qpos (預設為 3 個元素): 機器人身體部件的位置值。

qvel (5 個元素): 這些個別身體部件的速度(它們的導數)。

預設情況下,observation 不包括前端尖端的 x 和 y 坐標。可以通過在建構期間傳遞 exclude_current_positions_from_observation=False 來包含這些坐標。在這種情況下,observation space 將為 Box(-Inf, Inf, (10,), float64),其中前兩個 observations 是前端尖端的 x 和 y 坐標。無論 exclude_current_positions_from_observation 設定為 True 還是 False,x 和 y 坐標都會在 info 中返回,並帶有鍵 "x_position" 和 "y_position"。

但是,預設情況下,observation space 為 Box(-Inf, Inf, (8,), float64),其中元素如下

編號 |

Observation |

最小值 |

最大值 |

名稱(在對應的 XML 檔案中) |

關節 |

類型(單位) |

|---|---|---|---|---|---|---|

0 |

前端尖端的角度 |

-Inf |

Inf |

free_body_rot |

hinge |

角度 (rad) |

1 |

第一個 rotor 的角度 |

-Inf |

Inf |

motor1_rot |

hinge |

角度 (rad) |

2 |

第二個 rotor 的角度 |

-Inf |

Inf |

motor2_rot |

hinge |

角度 (rad) |

3 |

尖端沿 x 軸的速度 |

-Inf |

Inf |

slider1 |

slide |

速度 (m/s) |

4 |

尖端沿 y 軸的速度 |

-Inf |

Inf |

slider2 |

slide |

速度 (m/s) |

5 |

前端尖端的角速度 |

-Inf |

Inf |

free_body_rot |

hinge |

角速度 (rad/s) |

6 |

第一個 rotor 的角速度 |

-Inf |

Inf |

motor1_rot |

hinge |

角速度 (rad/s) |

7 |

第二個 rotor 的角速度 |

-Inf |

Inf |

motor2_rot |

hinge |

角速度 (rad/s) |

已排除 |

尖端沿 x 軸的位置 |

-Inf |

Inf |

slider1 |

slide |

位置 (m) |

已排除 |

尖端沿 y 軸的位置 |

-Inf |

Inf |

slider2 |

slide |

位置 (m) |

獎勵¶

總獎勵為:reward = forward_reward - ctrl_cost。

forward_reward:向前移動的獎勵,如果 Swimmer 向前移動(在正 \(x\) 方向 / 向右方向),則此獎勵為正值。\(w_{forward} \times \frac{dx}{dt}\),其中 \(dx\) 是(前端)「尖端」的位移 (\(x_{after-action} - x_{before-action}\)),\(dt\) 是 actions 之間的時間,這取決於

frame_skip參數(預設值為 4)和frametime,其為 \(0.01\) - 因此預設值為 \(dt = 4 \times 0.01 = 0.04\),\(w_{forward}\) 是forward_reward_weight(預設值為 \(1\))。ctrl_cost:懲罰 Swimmer 採取過大 actions 的負獎勵。\(w_{control} \times \|action\|_2^2\),其中 \(w_{control}\) 是

ctrl_cost_weight(預設值為 \(10^{-4}\))。

info 包含個別獎勵項。

起始狀態¶

初始位置狀態為 \(\mathcal{U}_{[-reset\_noise\_scale \times I_{5}, reset\_noise\_scale \times I_{5}]}\)。初始速度狀態為 \(\mathcal{U}_{[-reset\_noise\_scale \times I_{5}, reset\_noise\_scale \times I_{5}]}\)。

其中 \(\mathcal{U}\) 是多元均勻連續分佈。

Episode 結束¶

終止¶

Swimmer 永遠不會終止。

截斷¶

episode 的預設持續時間為 1000 個時間步。

引數¶

Swimmer 提供一系列參數來修改 observation space、獎勵函數、初始狀態和終止條件。這些參數可以在 gymnasium.make 期間以以下方式應用

import gymnasium as gym

env = gym.make('Swimmer-v5', xml_file=...)

參數 |

類型 |

預設值 |

描述 |

|---|---|---|---|

|

str |

|

MuJoCo 模型的路徑 |

|

float |

|

forward_reward 項的權重(請參閱 |

|

float |

|

ctrl_cost 項的權重(請參閱 |

|

float |

|

初始位置和速度的隨機擾動比例(請參閱 |

|

bool |

|

是否省略 observations 中的 x 和 y 坐標。排除位置可以作為歸納偏置,以誘導策略中與位置無關的行為(請參閱 |

版本歷史¶

v5

最低

mujoco版本現在為 2.3.3。新增了對使用

xml_file引數完全自訂/第三方mujoco模型 (先前只有少數變更可以對現有模型進行) 的支援。新增了

default_camera_config引數,這是一個用於設定mj_camera屬性的字典,主要用於自訂環境。新增了

env.observation_structure,這是一個用於指定 observation space 組成(例如qpos、qvel)的字典,對於為 MuJoCo 環境建立工具和 wrappers 非常有用。返回非空的

info和reset(),先前返回的是空字典,新鍵與step()的狀態資訊相同。新增了

frame_skip引數,用於配置dt(step()的持續時間),預設值因環境而異,請查看環境文件頁面。恢復了

xml_file引數(在v4中已移除)。新增了

forward_reward_weight、ctrl_cost_weight,以配置獎勵函數(預設值實際上與v4中的相同)。新增了

reset_noise_scale引數以設定初始狀態的範圍。新增了

exclude_current_positions_from_observation引數。將

info["reward_fwd"]和info["forward_reward"]替換為info["reward_forward"],以與其他環境保持一致。

v4:所有 MuJoCo 環境現在都使用 mujoco >= 2.1.3 中的 MuJoCo bindings。

v3:支援

gymnasium.makekwargs,例如xml_file、ctrl_cost_weight、reset_noise_scale等。rgb rendering 來自追蹤相機(因此智能體不會從螢幕跑掉)。v2:所有連續控制環境現在都使用 mujoco-py >= 1.50。

v1:max_time_steps 提高到 1000 以用於基於機器人的任務。為環境新增了 reward_threshold。

v0:初始版本發佈。